更多

分享

▲人工智能與人類。(圖/GETTY IMAGES)

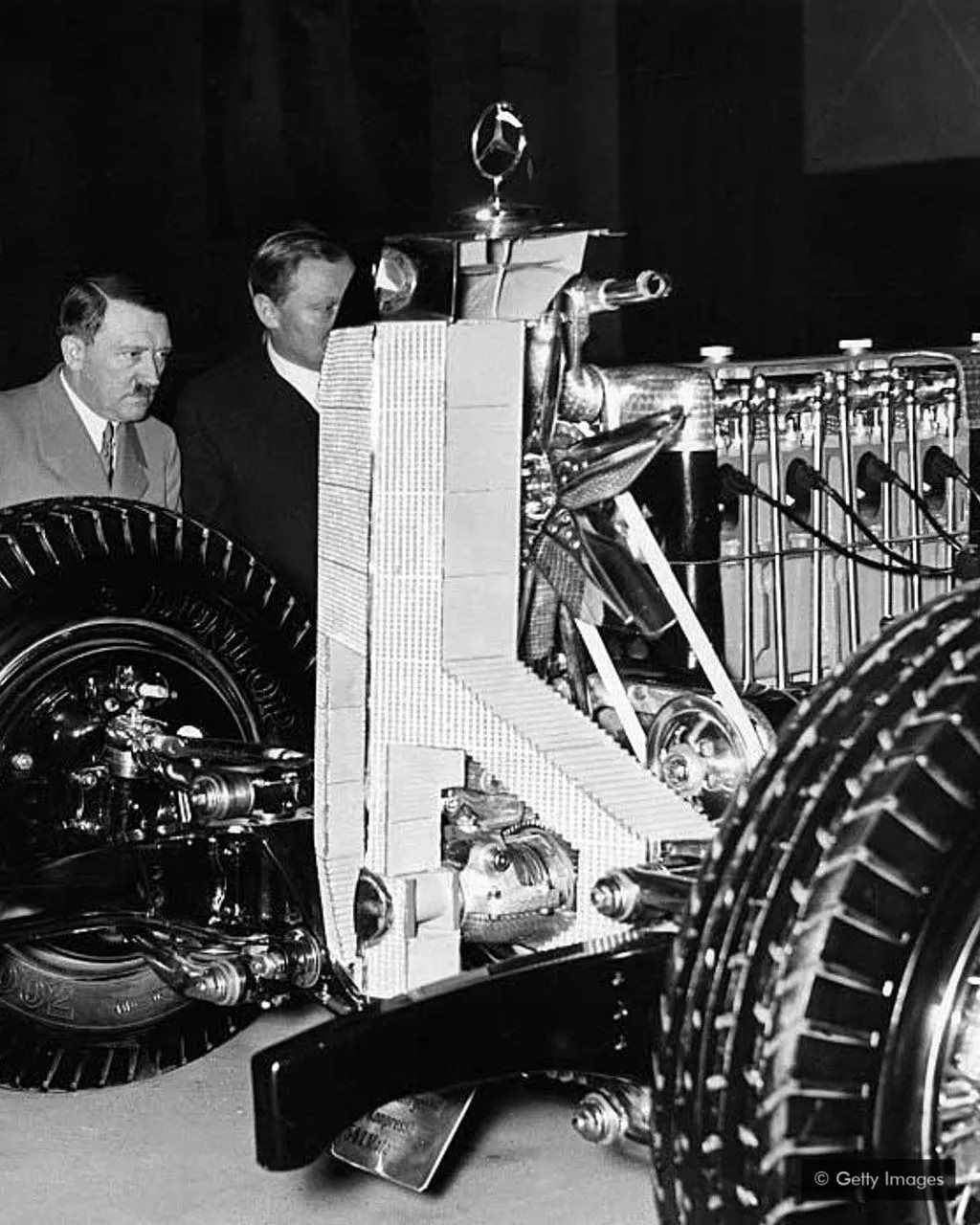

如果歷史上的極權政府未被打敗,如今它們會是什麼樣子?納粹使用的是20世紀的技術,直到二戰戰敗才終止發展。如果納粹比美國更早製造出原子彈,他們會有多強大,能撐多久?納粹如果掌握當時最先進的技術,可以鞏固權力,改變歷史進程。

當我們試想存在的風險時,像核戰爭或小行星撞擊這樣的慘劇經常浮現在我們的腦海中。然而,未來還有一個威脅不太為人所知——雖然它不太可能會讓人類滅絶,但同樣糟糕。

它就像「被鎖鏈鎖住的世界」,在這個場景中,就像曾經的思維實驗一樣,一個全球極權政府用新技術把世界上大多數人鎖在永久的痛苦之中。如果這聽起來很可怕,對,就是這樣。但這有可能嗎?研究人員和哲學家們開始思考它是如何產生的——更重要的是,我們能做些什麼來避免這種情況出現。

有可能的風險都是災難性的,因為它們把人類困在單一命運中,比如文明永久崩潰或人類滅絶。這些災難可能是由自然原因造成的,如小行星撞擊或超級火山爆發,也可能是核戰爭或氣候變化等因素造成的。劍橋大學存在風險研究中心(Centre for the Study of Existential Risk)的學術項目經理海頓·貝爾菲爾德(Haydn Belfield)表示,如果這種情況發生,將是「人類命運的悲慘結局」,並將讓我們愧對幾百代祖先。

牛津大學人類未來研究所(Future of Humanity Institute)高級研究員托比·奧德(Toby Ord)認為,本世紀發生自然災害的機率不到兩千分之一,因為沒有自然災害,人類已經存活了2000個世紀。然而,如果計算人為災難,奧德相信這種可能性會增加到驚人的六分之一。他把這個世紀稱為「懸崖」,意思是人類失去未來的風險從未如此之高。

倫敦一家非營利性研究機構——長期風險中心(Center on Long-Term Risk)的研究人員對未知風險進行了進一步研究,提出了更令人不寒而栗的預測。這些「超級風險」被定義為「天文級的痛苦,遠遠超過迄今為止地球上存在的所有痛苦」。「在這種情況下,數十億人仍存活,但質量極端低劣,前景黯淡,死亡將是更好的選擇。」簡而言之:一個負價值的未來比一個沒有價值的未來更糟糕。

這就是「被鎖鏈鎖住的世界」場景的由來。如果一個邪惡的組織或政府突然通過技術獲得了統治世界的權力,並且沒有什麼可以阻擋它,它可能會導致很長一段時間的人間苦難。2017年,全球優先項目(Global Priorities Project)與人類未來研究所和芬蘭外交部聯合發佈了一份關於潛在風險的報告,警告稱,「在漫長未來,人類如果由一個特別殘忍的全球極權國家統治,可能比徹底滅絶更糟糕」。

儘管全球極權主義仍是一個小眾研究主題,但潛在風險領域的研究人員正越來越多地將注意力轉向最有可能導致全球極權主義的原因:人工智能。

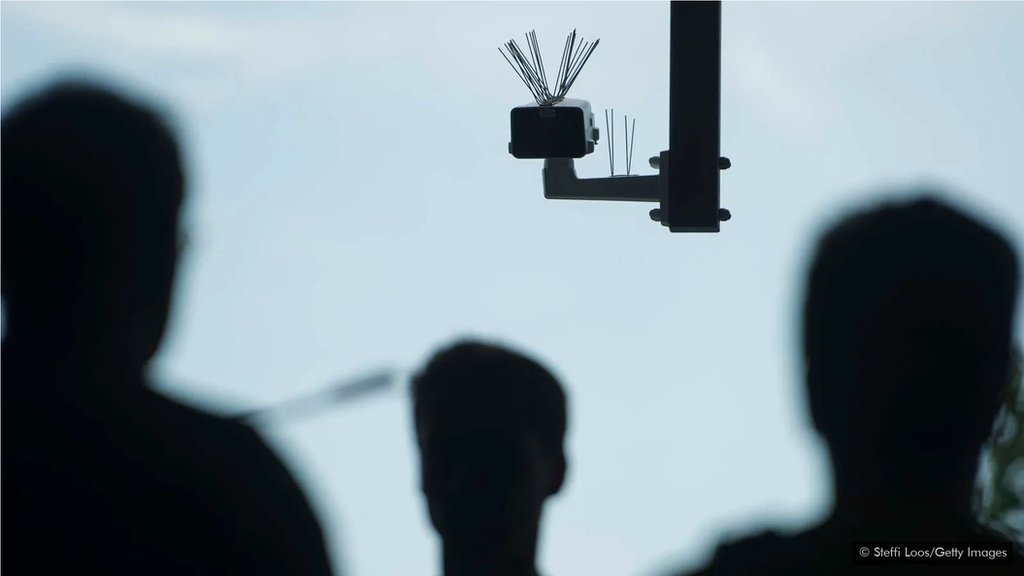

牛津大學人類未來研究所主任尼克·博斯特羅姆(Nick Bostrom)在他的《單例假說》(singleton hypothesis)中,解釋了如何利用人工智能或其他強大技術形成一個全球政府,以及它可能無法被推翻的原因。他寫道,如果該機構「利用人工智能或分子納米技術的突破取得決定性領先地位」,那麼就可能出現「最高級別單一決策機構」所掌控的世界。一旦掌權,它將全面利用防止內部挑戰的技術進步,如監視或自主使用武器,並在這種技術壟斷下保持永久穩定。

如果單一決策是極權主義的,人類文明將是暗淡的。曾經,即使是在制度最嚴格的國家,新聞也可以從其他國家流入,人們也可以選擇流亡。全球性的極權主義統治會徹底消滅這些希望。比滅絶更糟糕的是,「這將意味著我們完全沒有自由,沒有隱私,沒有逃脫的希望,完全沒有能力來控制我們的生活,」塔克·戴維(Tucker Davey)說,他是馬薩諸塞州未來生命研究所(Life Institute in Massachusetts)的一名作家,該研究所專注於潛在風險的研究。

「在過去的極權主義政權中,有太多的偏執和心理折磨,因為你不知道自己是否會因為說錯話而被殺,」他繼續說。「現在想象一下,甚至沒有這種問題,你說的每一句話都會被舉報和分析。」

奧德在最近的一次採訪中說:「我們可能目前還沒有技術實現這一點,但正在開發的技術讓這種狀況越來越有可能。」「在未來100年的某個時候,這似乎有可能成為現實。」

儘管極權政府統治全球仍不太可能,但人工智能已經在一些國家促成了威權主義,在另一些國家,機會主義暴君攫取了越來越多的基本公共權力。

「我們看到,人工智能帶給人類的未來,已經從非常的烏托邦轉變為反烏托邦,這發人深省。」新美國安全中心的兼職高級研究員埃爾莎·堪尼亞(Elsa Kania)說,這是一個無黨派非營利研究國家安全和國防政策的中心。

在過去,監視需要數十萬人參與,例如東德每100個公民中就有一個人是線人。但現在,這可以通過技術實現。在2019年停止國內監控之前,美國國家安全局(National Security Agency)收集了數億美國人的通話和短信記錄。據估計,英國各地有400萬到600萬個閉路電視攝像頭。全球最受監控的20個城市中,有18個在中國,但倫敦位居第三。它們之間使用的技術沒有差別,而差別更多的在於使用技術的方式。

如果美國和英國將非法行為的定義擴大到批評政府或信仰某些宗教會怎樣?利用信息技術監控的基礎設施已經沒有問題,而美國國家安全局已經開始使用人工智能進行試驗,各機構搜集數據能夠比以往更快。

除了加強監控,人工智能還能製造網絡虛假信息,這是威權政府可用的另一個工具。由人工智能製造的高級謠言工具,可以傳播虛假的政治信息,並通過算法在社交媒體上進行微觀定位,讓宣傳顯得更有說服力。這破壞了民主制度的根基,即公民的認知安全。人們無法確定什麼是事實,也無法據此採取行動。

貝爾菲爾德說:「在過去的幾年裏,我們看到了過濾信息導致的社會思潮和行動,人們被各種各樣的算法所誤導,開始相信各種各樣的陰謀論,即使這些不是完全意義上的陰謀論,也只是部分真相。」「你可以想象,事情會變得越來越糟,尤其是深度造假之類的事情,直到我們越來越難以作為社會群體,決定哪些是事實,是我們必須做的,然後採取集體行動。」

由貝爾菲爾德和來自14個機構的25位作者撰寫的《惡意使用人工智能》(The Malicious Use of Artificial Intelligence)報告預測,這樣的趨勢將使政治安全受到更加嚴重的威脅,並在未來幾年新的威脅不斷出現。儘管如此,貝爾菲爾德說他的工作讓他充滿希望,而積極的方面,比如關於人工智能的民主的討論和政策制定(例如,歐盟考慮在公共場所暫停面部識別),讓我們對避免災難性的命運仍然可以保持樂觀。

戴維也同意這個說法。「我們現在需要決定:使用人工智能,怎樣是可接受?怎樣是不可接受的?」「我們需要小心,不要讓它控制我們的這麼多基礎設施。如果我們給警察配備了面部識別系統,而聯邦政府因此可以收集我們的所有數據,那是個糟糕的開始。」

如果你對人工智能是否有如此強大的力量仍持懷疑態度,不妨想想核武器即將被發明前的世界。在第一次核鏈式反應的三年前,即使是試圖實現這一目標的科學家也認為這是不可能的。人類也沒有為核能突破做好凖備,在各種條約和協定出台,限制這種致命武器在全球擴散之前,幸好沒有發生巨大的災難,而那時,人類是徘徊在"相互毀滅"的邊緣。我們應將歷史教訓與遠景結合起來,為發明某種強大的技術做好凖備。我們可以在人工智能方面做同樣的事情。

世界或許無法阻止像納粹那樣的極權主義政權在未來再次崛起,但我們至少可以避免讓他們擁有無限的權力。